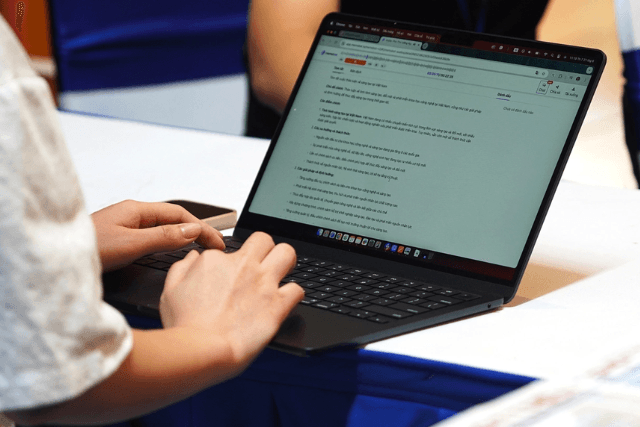

Khi thấy bản kế hoạch được trình bày gọn gàng, sắc sảo, anh Thanh Quang – giám đốc một công ty truyền thông – ban đầu vui mừng vì tưởng nhân viên đã tiến bộ. Nhưng niềm vui nhanh chóng nhường chỗ cho lo lắng khi biết rằng toàn bộ nội dung trong kế hoạch đã được đưa vào công cụ AI để xử lý – bao gồm cả những thông tin bí mật liên quan đến khách hàng và chiến lược chưa công bố.

Nhân viên sử dụng ChatGPT để nhờ hỗ trợ mà không nhận ra rằng hành động này có thể khiến dữ liệu quan trọng không còn nằm trong tầm kiểm soát nội bộ. “Các em nghĩ rằng chỉ trò chuyện với AI thì chẳng ai khác biết được. Nhưng thực tế không đơn giản như vậy”, anh Quang nói.

Đây là một ví dụ điển hình của Shadow AI – tình trạng nhân viên tự ý dùng các công cụ AI mà không được phê duyệt hay giám sát từ bộ phận công nghệ thông tin. Hiện tượng này bắt nguồn từ khái niệm “Shadow IT” vốn chỉ việc sử dụng phần mềm, hệ thống ngoài tầm kiểm soát chính thức trong tổ chức.

Theo báo cáo mới nhất về an ninh mạng 2025 của Cisco, 62% tổ chức tại Việt Nam thừa nhận khó giám sát việc nhân viên dùng AI không thông qua kiểm soát chính thức. Thậm chí, 40% bộ phận CNTT không nắm được cách thức sử dụng AI của nhân viên, dù 44% trong số đó dùng công cụ đã được phê duyệt.

Khi AI trở thành con dao hai lưỡi

Anh Nguyễn Hoàng – trưởng phòng kinh doanh tại một startup ở Hà Nội – từng khuyến khích đội ngũ tận dụng AI, thậm chí còn mua tài khoản ChatGPT Plus dùng chung cho cả phòng. Nhưng sau một lần xem lại lịch sử trò chuyện, anh phát hiện một nhân viên đã vô tình tiết lộ nhiều thông tin nội bộ nhạy cảm trong quá trình hỏi AI về cách cải thiện chăm sóc khách hàng.

“Tôi hiểu cậu ấy chỉ muốn được tư vấn cụ thể, nhưng vô tình lại làm lộ bí mật kinh doanh”, anh Hoàng chia sẻ, đồng thời thừa nhận không có giải pháp bảo mật hiệu quả vì doanh nghiệp còn nhỏ.

Theo ông Nguyễn Như Dũng – Tổng giám đốc phụ trách thị trường Việt Nam, Lào và Campuchia của Cisco – các nhóm an ninh mạng đang gặp khó khăn trong việc vừa đảm bảo tính bảo mật cho ứng dụng AI nội bộ, vừa bảo vệ người dùng trước rủi ro từ các nền tảng bên ngoài.

Còn ông Vũ Ngọc Sơn, Trưởng ban Nghiên cứu thuộc Hiệp hội An ninh mạng quốc gia (NCA), cho rằng Shadow AI là mối nguy lớn vì gây ra lỗ hổng từ cả con người, quy trình lẫn công nghệ. Thực tế, nhiều nhân viên đã từng đưa lên AI những dữ liệu quan trọng như mã nguồn, báo cáo tài chính, chiến lược kinh doanh mà không ý thức rõ rủi ro.

Nội dung người dùng nhập vào ChatGPT và các AI tương tự thường được hệ thống ghi lại để phục vụ huấn luyện mô hình. Trừ khi người dùng chủ động tắt tính năng ghi nhớ hội thoại hoặc dùng chế độ tạm thời, dữ liệu có thể bị lưu trữ và phân tích. Trong khi đó, nhiều người không biết cách hoặc thậm chí không nhận thức được điều này.

Thiếu quy trình, thiếu kiểm soát

Theo đánh giá từ NCA, đa phần doanh nghiệp hiện chưa xây dựng quy trình rõ ràng về việc ai được dùng AI, được dùng trong tình huống nào, loại dữ liệu nào không được đưa vào AI. Điều này dẫn đến tình trạng sử dụng tùy tiện và mất kiểm soát.

Công nghệ AI phát triển quá nhanh, khiến phần lớn các tổ chức chỉ tập trung vào khả năng xử lý mạnh mẽ, mà bỏ quên những yêu cầu về bảo mật và quyền riêng tư. Sự thiếu hụt hiểu biết kỹ thuật lẫn chính sách rõ ràng càng làm trầm trọng thêm nguy cơ.

Giải pháp nào để kiểm soát Shadow AI?

Để giảm thiểu rủi ro từ Shadow AI, các chuyên gia khuyến cáo doanh nghiệp cần:

- Ban hành chính sách cụ thể về sử dụng AI, trong đó nêu rõ loại dữ liệu được phép chia sẻ, loại hình ứng dụng được chấp nhận, quy trình kiểm tra và giám sát nội dung AI sử dụng.

- Tăng cường đào tạo nội bộ, giúp nhân viên nhận thức rõ ràng hơn về nguy cơ rò rỉ thông tin và các điều khoản sử dụng công cụ AI.

- Ứng dụng công cụ bảo mật chuyên biệt để kiểm tra và giám sát tương tác với AI, nhận diện hành vi rủi ro hoặc hành vi ngoài phạm vi phê duyệt.

- Cơ quan quản lý cần vào cuộc, ban hành tiêu chuẩn về hệ thống AI được phép sử dụng trong các tổ chức, tùy theo mức độ nhạy cảm của dữ liệu.

Trên thế giới, Shadow AI đang trở thành mối lo ngại chung. Nhiều tổ chức tại Mỹ đã thẳng tay cấm nhân viên sử dụng chatbot AI không qua phê duyệt, đặc biệt sau khi các mô hình AI mã nguồn mở như DeepSeek ra mắt với giá rẻ và dễ tiếp cận.

“Chỉ 55% nhân sự tại Việt Nam được đánh giá là thực sự hiểu rõ các rủi ro liên quan đến AI. Điều đó cho thấy, ngoài chính sách và công nghệ, việc nâng cao nhận thức người dùng là yếu tố tiên quyết để kiểm soát Shadow AI”, ông Dũng kết luận.